ドライバーの目線などを検知して必要なアシストを行う

AIは安全にどう貢献するか

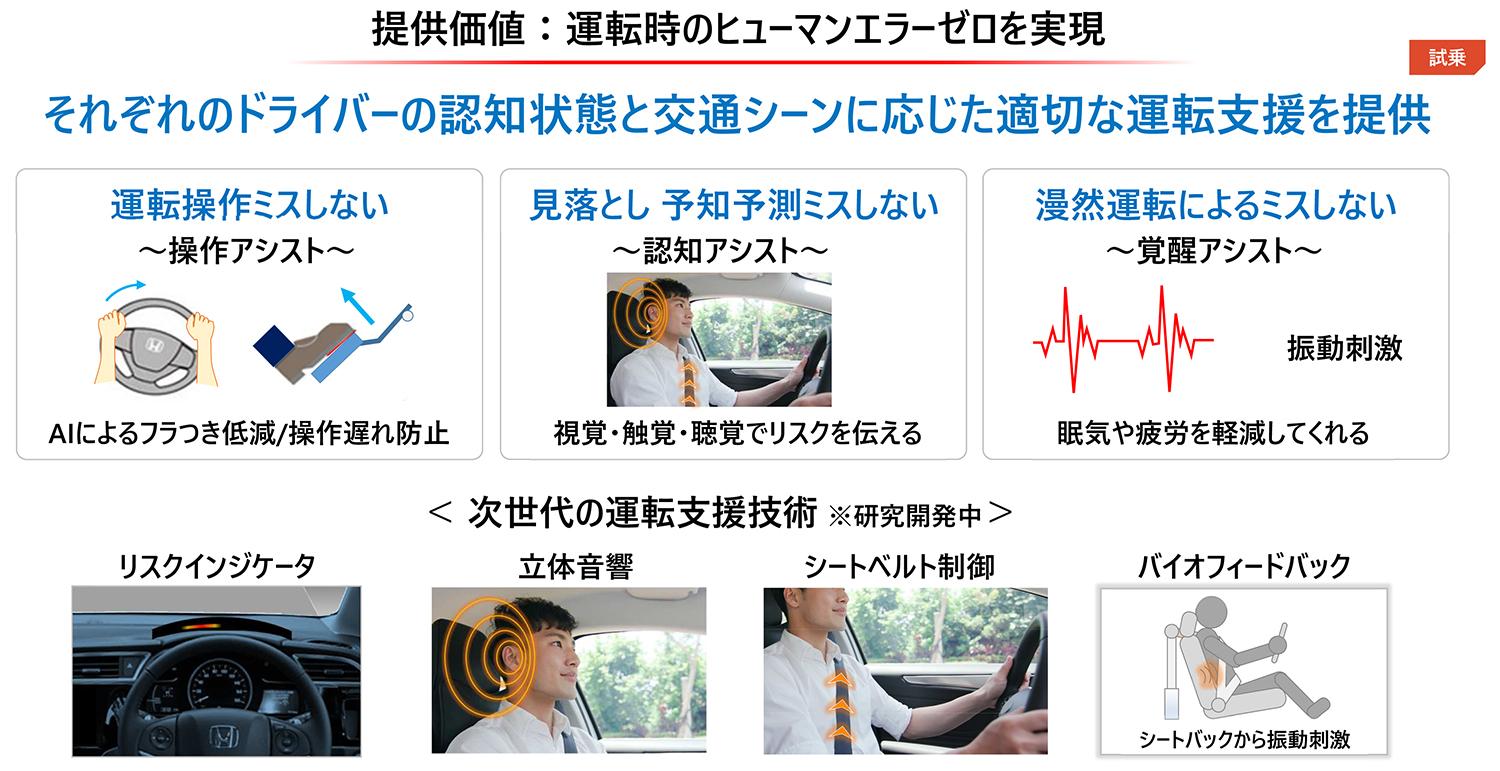

今回発表されたホンダの「知能化運転支援技術」は、ADASやドライバーの運転入力操作、視線の動きを統合データ化する。早い話が、センシングによって得られた情報からAIが潜在的リスクを検出し、ドライバーの認知状況と交通シーンに合わせて、最適な運転行動をリアルタイムで予測判断する、そんな次世代HMI(ヒューマン・マシン・インターフェイス)なのだ。

次世代HMIを搭載したテストカーのフロントスタイリング画像はこちら

次世代HMIを搭載したテストカーのフロントスタイリング画像はこちら

今のところ具体的な支援機能としては3点。フラつきを抑える「操作アシスト」、ドライバーの見落としや予知予測ミスを防ぐ「認知アシスト」、さらには漫然と集中力が途切れることで起きるミスを防ぐ「覚醒アシスト」が挙げられる。

心拍センサー付きのリストバンドを巻いて、試験車両のシャトルの運転席に座ると、通常のタッチスクリーンには自分の心拍グラフが、メーターパネル上にはリスクインジケーター、さらにダッシュボード中央付近にはドライバーをモニターするカメラが見える。心拍センサーでドライバーの意識を運転集中へと誘導するよう、心拍を上げるパルス振動がシート背面に埋め込まれたバイブレーターから伝わってくる。これがスタート前の「覚醒アシスト」だ。視線がトロンとして瞼が重くなった時にも、パルス振動は送られてくるだろう。

テストカーのディスプレイに表示される心拍イメージ画像はこちら

テストカーのディスプレイに表示される心拍イメージ画像はこちら

走り出して直進しながら道路左側、路駐した2台を見やると、シートベルトがモーターでキュッと締まって注意喚起が促される。走行中には見えない2台の間に歩行者がいて、ルーフ上のカメラからは見えていたというのだ。センシングによるリアル状況と運転者の状況認知、両者の間で起きる「時空間のズレ」を、AIが見守り続けるというのが「認知アシスト」の基本的な考え方といえる。

次世代HMIを搭載したテストカーによる走行体験画像はこちら

次世代HMIを搭載したテストカーによる走行体験画像はこちら

続いては右折直後、横断歩道の手前で停止した後、歩行者が横断を終えかけて進もうとした瞬間、シートベルトが引っ張られた。すると死角から自転車が飛び出してきた。意識が歩行者に向いて、もう来ないだろうと予知しがちなことによる「状況不認知」を、認知アシストが援けてくれるという例だ。

次世代HMIを搭載したテストカーによる走行体験画像はこちら

次世代HMIを搭載したテストカーによる走行体験画像はこちら

ちなみに試験車両のシャトルは四隅にカメラを載せたルーフボックス状のケースを屋根に積んでいたが、これは実験用モジュールを頻繁に入れ替える都合ゆえで、実際には前方2隅のカメラはルームミラー一体化型カメラで同じ機能が果たせるという。

次世代HMIを搭載したテストカーの実験用カメラモジュール画像はこちら

次世代HMIを搭載したテストカーの実験用カメラモジュール画像はこちら

課題は警告インターフェイス

認知アシストのデモ例はもう1パターン。左側走行車線を直進中、駐停車中のクルマがあって車線変更しようとしたところ、追越車線ではバイクが自車を死角から、優速で追い越している最中だった。この時はシート肩口のスピーカーから立体音響で警告音が鳴った。

次世代HMIを搭載したテストカーによる走行体験画像はこちら

次世代HMIを搭載したテストカーによる走行体験画像はこちら

かくして今現在、認知アシストがこなせるパターンを3つ体験してみたのだが、リスクを伝える視覚・聴覚・触覚の各チャンネルが効果的でなく、インターフェイスの練り込みが足りないと感じた。

まず視覚上、メーター上のグラフ式インジケーターはいかにも旧態然としているし、ウインドウスクリーンかヘッドアップディスプレイ上に、AR技術で現実の視界にオーバーレイする方が直観的でわかりやすいだろう。肩口スピーカーの立体音響はリアルな音が出せるが、警告としてはドアミラーのブラインドスポットモニターと被るところではある。さらに触覚チャンネルついては、シートベルト巻き取りや背中のパルス振動だけではリスクの方向性・指向性が表せない。シート座面からも左右の振動や強弱で分けたり、視覚チャンネルと組み合わせるなど、工夫が要るだろう。

次世代の運転支援技術における認知アシスト画像はこちら

次世代の運転支援技術における認知アシスト画像はこちら

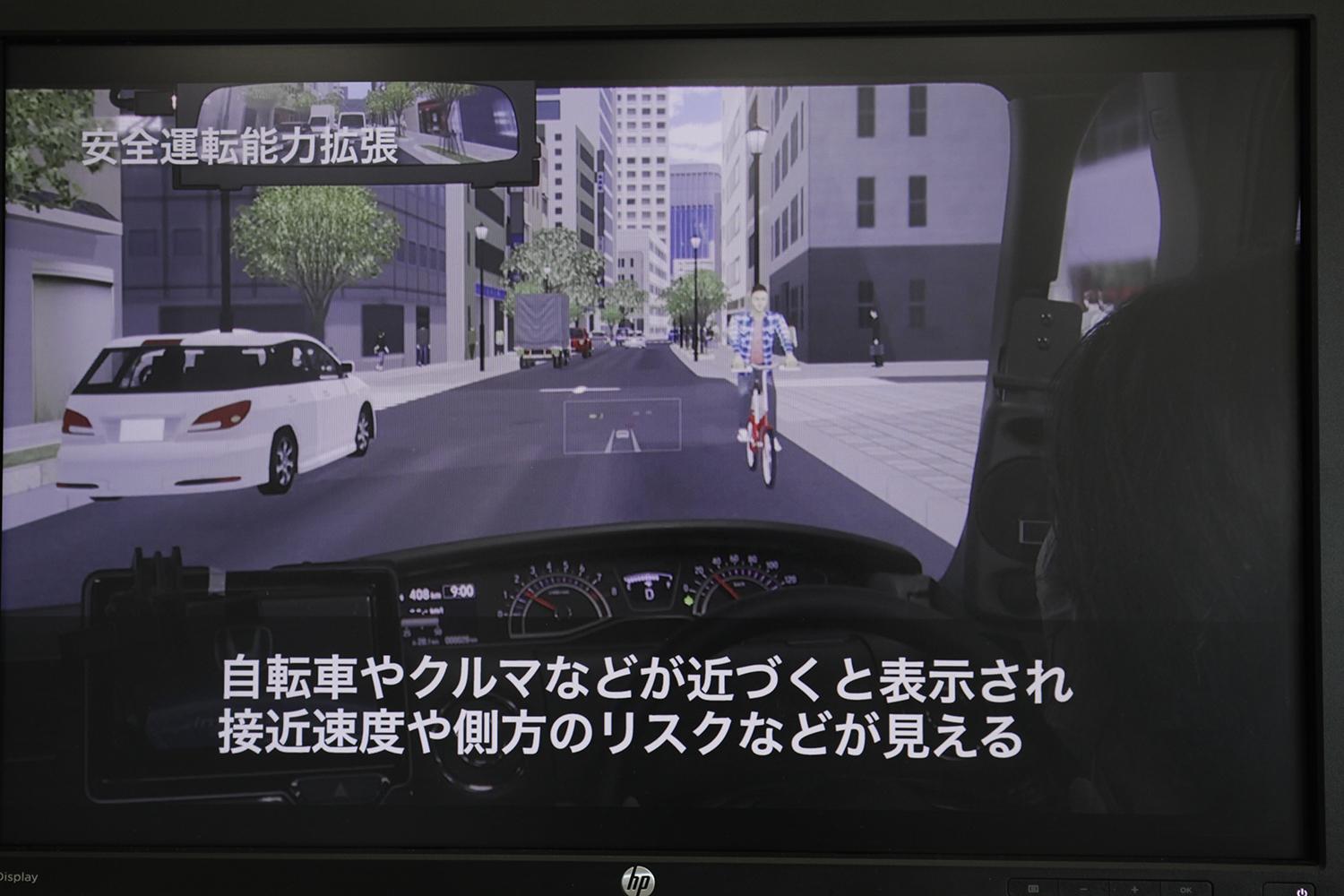

テストコース上では試せなかった「操作アシスト」については、まず一の橋から浜川崎までの首都高C1をシミュレータで体験した。平日朝を思わせる路上のささくれた空気感が見事に再現されていて、フラフラ走るワンボックスやミニバン、割り込みをするセダン、アオって来るSUVなど、リスク選好型の他車をN-BOXでかき分けていくイメージだ。

ドライブシミュレーターによる操作アシスト体験のイメージ画像はこちら

ドライブシミュレーターによる操作アシスト体験のイメージ画像はこちら

最初は操作アシスト無しで走ると、車線はみ出しや急ブレーキ、後ろをツメてくる他車を相手に、少なからぬヒヤリハットが起きる。同じ状況を操作アシストONで行くと、ドライバーの視線の動きや他車リスクの認識度に応じて、リスク蓋然性をAIが先読み予測し、フラつきや操作遅れ、減速ブレーキを援けてくれる。突然に介入するというより、ヒヤッとする前にスっと自分とは別の意識が働いてくれる感覚で、ステアリング修正舵以外はほぼ違和感がない。

この傾向はみゆき通り直進という市街地シミュレーションでも顕著で、向かい合って進んでくる自転車がフラついたり、目の前を別のクルマが飛び出したりする状況でも、操作アシストは知っていたかのように自然に介入する。センサーがキューとなって発動される現状のADAS機能とは、明らかな差がある。

ドライブシミュレーターによる操作アシスト体験のイメージ画像はこちら

ドライブシミュレーターによる操作アシスト体験のイメージ画像はこちら

ここでもカギとなるのは他車・他者という外在的リスク、つまり歩行者や自転車だが、今やモーションキャプチャーなどを使うことなく、カメラに映った通行人の手足関節や耳の位置を認識できるという。そこから顔の正面や骨盤の向きを判別し、進んでくる方向や数秒後の位置を予測しているのだとか。

ただし、こちらシミュレータのリスク表示はヘッドアップディスプレイだったが、映し出される幅が狭く、10時方向にあるリスクが11時方向にしか出てこないので、結局のところ、どれがリスクで、どの程度認知済みのリスクなのかわかりづらいことがあった。

ドライブシミュレーターによる操作アシスト体験のイメージ画像はこちら

ドライブシミュレーターによる操作アシスト体験のイメージ画像はこちら

もうひとつの難点は、度付きサングラス着用で臨んだところ、目の動きをモニターするカメラが認識してくれなかった。サングラスをかけての日中運転以外にも、トンネルに入ったり夜間走ることは当然ありうるので、赤外線カメラなどにするべきだろう。

ドライブシミュレーターによる操作アシスト体験をする南陽さん画像はこちら

ドライブシミュレーターによる操作アシスト体験をする南陽さん画像はこちら

いずれも表示インターフェイスに課題ありだが、予測技術として認識の精度には舌を巻いた。

ホンダの「2050年交通事故死者ゼロに向けた、先進の将来安全技術」の体験会にはまだまだ驚かされたのだが、つづきは次回に。(その2につづく)